Llevar a cabo labores de Vigilancia tecnológica e Inteligencia Competitiva resulta indispensable para cualquier empresa. En este artículo se abordan sistemas prácticos para llevar a cabo dichas labores.

En concreto, una de las fuentes más útiles, y de las menos explotadas, es la Web Oculta.

La Web Oculta la componen aquéllas páginas que se generan de forma dinámica tras la ejecución de un recurso bien en el lado cliente o en el lado servidor, típicamente tras realizar una consulta a una base de datos, no siendo accesibles por las tecnologías de búsqueda convencionales.

Contiene la información más rica, la que puede proporcionar mayor valor para la Inteligencia Competitiva.

Mediante tecnologías de estructuración automática es posible consultar esta información como si de una base de datos convencional se tratase. Ello facilita la confección de indicadores para el proceso de Inteligencia competitiva, a la vez que la creación de portales con información personalizada y otras aplicaciones.

1. La Vigilancia como estrategia

La capacidad de innovación en un mercado cada vez más competitivo determina quienes pueden diferenciarse del resto de sus competidores y así incrementar los ingresos por la comercialización de sus productos o servicios.

En consecuencia, para toda empresa es hoy día una exigencia máxima el mantenerse puntualmente informada de lo que acontece a su alrededor:

- Patentes relacionadas con los productos de la empresa.

- Nuevas regulaciones y legislación.

- Productos y precios de la competencia.

- Avances científicos en medios especializados.

- Alianzas y fusiones de competidores, clientes y suministradores.

- Noticias de relevancia del sector.

- Ferias y eventos.

- Ayudas y subvenciones publicadas en boletines oficiales locales, nacionales e internacionales.

Gran parte de esta información está disponible en tiempo real en Internet, pero su recogida y explotación se ven dificultadas por la dispersión y heterogeneidad de las fuentes.

El proceso, realizado de forma manual o con herramientas genéricas, mal adaptadas o incompletas, se convierte habitualmente en un proceso parcial, aleatorio, lento y poco estructurado.

Además, es también frecuente que los responsables de las tareas de vigilancia dediquen su tiempo a la labor de recolección de datos, en lugar de analizar dichos datos y transformarlos en Inteligencia Competitiva.

La organización compromete así gran parte de sus recursos en la obtención de la información, lo que genera resultados muy pobres.

Claramente, son necesarias soluciones que ayuden a la sistematización y automatización de estas actividades. Estas soluciones de Vigilancia Tecnológica se enfrentan a tres retos principales:

- Cómo acceder a información de Internet, automatizando tareas como el rellenado de formularios, el seguimiento de enlaces, los mecanismos de autenticación o el mantenimiento de sesión.

- Cómo extraer ítems de información (estructuración) de páginas HTML u otros tipos de información semiestructurada.

- Como mantener con agilidad estos sistemas ante cambios en los sitios web sujetos a vigilancia.

2. Inteligencia Competitiva

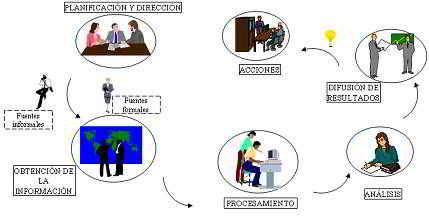

La Inteligencia Competitiva (o Vigilancia Tecnológica; la mayor parte de los expertos utiliza estos términos de forma intercambiable a pesar de orígenes divergentes) podría definirse como el esfuerzo sistemático de observación, captación, análisis, difusión y recuperación de información en los entornos tecnológico y de negocio.

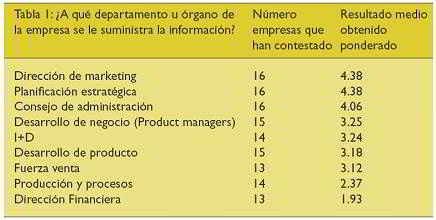

Según un estudio de la revista Puzzle, líder en el campo de Inteligencia Competitiva, ésta toca en mayor o menor medida todos los departamentos de la empresa, como se puede ver en el cuadro a continuación:

Dicho estudio también concluyó que las actividades más frecuentes y que consumían la mayor cantidad de recursos de las unidades de Inteligencia Competitiva eran las siguientes:

- Búsqueda

- Clasificación

- Análisis

- Distribución

3. Web Oculta

La paradoja radica en que la mayoría de la información disponible en Internet no es visible para las herramientas tradicionalmente utilizadas en la búsqueda y explotación de dicha información: nos estamos refiriendo a la llamada “Web Oculta”,

y cómo los buscadores, por regla general, no son capaces de mostrárnosla.

Pero ¿qué es la Web Oculta (también referida como Web Dinámica o Invisible)? Raghavan y García Molina (2001) distinguen tres tipos de dinamismo en páginas web:

- Dinamismo temporal (Temporal dynamism): es el dinamismo resultante de contenido temporal, por ejemplo las cotizaciones de la bolsa o de tipos de cambio o de noticias.

- Dinamismo de cliente (Client dynamism): el contenido que se sirva a un cliente es diferente de otro, como en el caso de Amazon, con sus recomendaciones personalizadas.

- Dinamismo de inserción (Input dynamism): los resultados de insertar palabras clave en formularios.

La Web Oculta está ligada al tercer tipo de dinamismo en páginas Web descrito por Raghavan y García Molina, el dinamismo de inserción, es decir aquellas páginas web que son generadas de forma dinámica a partir de consultas generalmente realizadas a bases de datos, con las que se interactúa a través de formularios.

La dificultad en acceder a dicha información por parte de los crawlers actuales radica en que:

- En muchos casos los formularios de consulta no aparecen expuestos en el código de las páginas directamente, sino que son fruto de la ejecución de programas embebidos en las mismas (e.g. código Javascript), por lo que los crawlers no tienen acceso a los mismos[1].

- por otro lado, en aquellos casos en los que puedan acceder al formulario, no sabrían cómo realizar búsquedas sobre el mismo y cuáles serían las palabras clave de búsqueda a insertar en los diferentes campos ya que desconocen el contenido y la semántica de la información existente detrás del formulario de consulta.

- Muchas de las fuentes de información son bajo registro y exige que el robot pueda suministrar un login y password del que no dispone.

El tamaño de la Web Oculta es sensiblemente superior a la de la Web convencional o estática: contiene según diferentes estimaciones hasta 500 veces la información indexada por buscadores (7500 terabytes vs. 19 terabytes en un estudio realizado por BrightPlanet en el año 2000 (Michael K. Berg 2000)), de ahí el interés en el desarrollo de tecnologías que permitan explotar adecuadamente esta información.

En el resto de este artículo presentamos las tecnologías que permiten el acceso a la Web Oculta, y cómo las mismas pueden proporcionar una visión estructurada de sus contenidos que facilite su tratamiento mediante motores de consulta similares a los de las bases de datos relacionales, lo que permite construir aplicaciones de inteligencia competitiva de alto valor añadido.

4. Las fuentes de información semiestructuradas

La importancia de la Web Oculta no deriva no obstante de la cantidad de información que contiene, sino principalmente de la calidad de la misma: todo lo que está detrás de un formulario tendrá una calidad mucho mayor de lo que podamos encontrar antes (por ejemplo, el formulario de búsqueda de proyectos de investigación no guarda ninguna relación con la cantidad y calidad de información accesible a través de él en bases de datos como Cordis).

La información más valiosa se encuentra almacenada en bases de datos y es accesible en Internet mediante formularios de consulta, tal y como manifiesta Francois Libmann en una reciente entrevista a la revista Regards sur I’IE (Francois Libmann 2005).

La propiedad más importante que caracteriza a la Web Oculta es que su información está semiestructurada (o, lo que es lo mismo, débilmente estructurada). ¿Qué quiere decir esto?: pues que a diferencia de la información que típicamente reside en la Web estática, fundamentalmente no estructurada, esta información ha sido generada de forma dinámica por un programa, por lo que intrínsecamente existe una estructura subyacente a la información, que puede ser inferida por medios automáticos para su mejor aprovechamiento.

Y ahí está la principal ventaja de la información residente en la Web Oculta: puede ser procesada de forma automática una vez que ha sido estructurada, por lo que puede consultarse con lenguajes de consulta muy potentes similares a los que nos ofrecen las bases de datos modernas.

5. Técnicas de Estructuración de Información

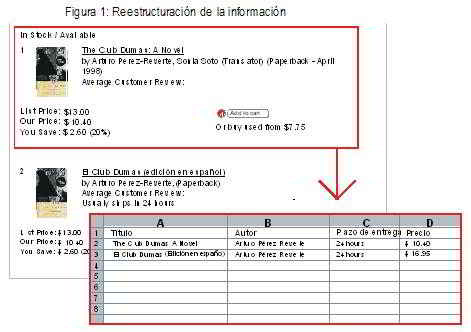

Para ello, como paso previo, es precisa la estructuración de la información. En la actualidad existen tecnologías que permiten inferir la estructura de las páginas de la fuente detectando automáticamente delimitadores que nos marquen la separación de un registro o de un campo al siguiente.

De esta forma es posible construir de forma automática un extractor (también llamado envoltorio) que consiga traducir la fuente a una tabla de datos con atributos de igual forma que podemos encontrarnos en una base de datos convencional.

El proceso que sigue el usuario para extraer datos de la web oculta es muy sencillo:

- El usuario graba su navegación por las páginas de llegada al formulario, autenticación, inserción de datos y recogida de resultados.

- El usuario identifica los resultados de interés utilizando para ello tres o cuatro ejemplos de resultados.

- La herramienta genera patrones de navegación y extracción, así como de definición de la estructura de la fuente en base a esos ejemplos.

- Si el formato de la fuente cambia, el sistema intentará realizar el proceso inverso, en el que trata de localizar en las nuevas páginas los ejemplos de resultados obtenidos previamente e infiere a partir de ellos el nuevo patrón de la fuente regenerándose de forma automática.

De modo que el paradigma de Web Semántica puede estar próximo, ya que gracias a técnicas de estructuración automática como las mencionadas podemos ofrecer una etiquetación automática del contenido del site, que nos permita poder interpretar por parte de un computador tanto su contenido como los servicios y posibles consultas que el mismo ofrece.

6. El potencial de las fuentes de información semiestructuradas para la Inteligencia Competitiva

Volviendo al punto original, la información ya estructurada puede ser explotada de forma muy potente mediante técnicas de bases de datos, que combinen información de distintas fuentes, por lo que podemos responder consultas del tipo:

- Obtener el montante medio de financiación en proyectos de I+D en tecnologías UMTS financiado por la Programa de I+D de la Unión Europea en el periodo 2002 – 2004.

- Construir una base de datos con todas las empresas del sector químico que hayan invertido en Sudamérica más de 5 MEUR entre los años 2000 y 2005.

- Obtener la evolución de patentes por país en nanotecnología durante los últimos cinco años.

Información de este tipo es claramente de mucho valor añadido para los órganos de decisión de cualquier empresa. Entre las ventajas de estos sistemas figuran el que podamos construir cuadros de mando con indicadores para visualización en el proceso de inteligencia competitiva, como por ejemplo, extrayendo datos de patentes, noticias, revistas especializadas, etc.,

y agregándolas todas en una sola página, un portal para la inteligencia competitiva donde veamos la evolución de una tecnología por número de patentes registradas, las últimas noticias extraídas de webs de competidores, así como las noticias del sector por productos y tecnologías, todo extraído de diferentes fuentes, en tiempo real, y con la información de la competencia.

Un sistema de Vigilancia Tecnológica/Inteligencia Competitiva que ignorase la información escondida en bases de datos de artículos, tecnologías, patentes, etc. sería completamente inadecuado. La exploración de esta web oculta necesita del descubrimiento de las bases de datos relevantes y su incorporación a un sistema de exploración sistemática y automatizada.

Es necesario el realizar una relación completa de las palabras clave que nos interesan (productos, tecnologías, competidores, eventos, suministradores, etc.), para disponer de la última información actualizada. Entonces podemos lanzar regularmente nuestro sistema automatizado contra bases de datos relevantes, y disponer de una indexación de la web personalizada.

El sistema permitiría también la elaboración de estadísticas que pueden avisar sobre sectores y tecnologías emergentes descubriendo en qué campos se está trabajando más (con la generación de indicadores por tecnologías, patentes, artículos, productos, competidores, etc.).

7. Últimas tendencias tecnológicas para la exploración de la Web Oculta

Una lista parcial de bases de datos buscables en internet (Francois Libmann 2005) revela que existen más de 150.000 bases de datos que no están indexadas en Internet.

Algunas herramientas permiten la búsqueda simultánea y centralizada en cada una de ellas de un cierto número de palabras clave, y luego la posterior agregación del contenido.

Este tipo de herramientas permite la labor de descubrimiento de fuentes que complementa a lo que se puede hacer vía otros buscadores, y que es la labor previa a la puesta en marcha de un sistema de vigilancia tecnológica automatizado.

En la actualidad se está investigando activamente en técnicas de crawling especializadas en la Web Oculta (Raghavan y García Molina 2001).

El usuario proporciona al robot una descripción del dominio en el que está interesado (e.g. bases de datos de patentes), consistente en una relación de etiquetas típicas de campos de búsqueda en dicho dominio así como ejemplos de ítems de información válidos para el mismo.

El robot analiza los formularios de las páginas y utilizando técnicas de similitud textual y proximidad visual genera un ranking en función de la relevancia de los formularios encontrados con respecto al dominio de interés; a continuación realiza búsquedas utilizando los ejemplos suministrados con objeto de validar la página, y recuperar la información contenida en la misma.

Otra variante tecnológica relacionada es lo que se conoce como Focussed Crawling (Chakrabarti et al., 1999), en este caso el robot recorre enlaces al modo tradicional (sin cruzar formularios) y analiza los documentos de la página comparándolos con los que son referencia en el dominio de interés utilizando técnicas de catalogación automática.

Estas técnicas se basan en la generación de vectores de claves obtenidos a partir de documentos representativos del dominio que han sido proporcionados previamente por el usuario.

Cuando el crawler obtiene un documento realiza el mismo proceso calculando el vector de claves para el mismo, a continuación calcula la proximidad con el documento que sirve de patrón para dicho dominio, descartando aquéllos que no pertenezcan al dominio de interés.

De este modo podríamos construir un buscador especializado por ejemplo en nanotecnología, y que nos construyese un índice con toda la información disponible en Internet relativa a esta temática.

8. Conclusión

Las técnicas de estructuración automática permiten obtener una visión estructurada de la información que reside en la Web Oculta. Ello facilita la creación de indicadores para el proceso de la Inteligencia Competitiva basados en potentes consultas en las que se recoge información de forma combinada de diversas fuentes.

En definitiva las tecnologías que permiten una explotación adecuada de la información residente en la Web Oculta pueden proporcionar un alto valor añadido para la construcción de aplicaciones de Inteligencia Competitiva, ya que abren un universo de posibilidades hasta ahora desconocido.

Bibliografía

Raghavan y García Molina. “Crawling the Hidden Web”. En: Proceedings of the 27th International Conference on Very Large Data Bases (VLDB 2001), 2001, Morgan Kaufmann, pp. 129 -138.

Michael K. Berg, «The Deep Web: Surfacing Hidden Value», BrightPlanet White Paper, 24 de Septiembre de 2001

Francois Libmann. «Web Invisible: Le Rideau Tombe!», 2005. En Regards sur l’IE, Mayo-Junio 2005.

Juan Raposo, Alberto Pan, Manuel Álvarez, Ángel Viña. “Automatic Wrapper Maintenance for Semi-Structured Web Sources Using Results from Previous Queries”. En: Proceedings of the 2005 ACM Symposium on Applied Computing. (SAC 2005), 2005, The Association for Computing Machinery, Inc., pp. 654-659.

Alberto Pan, Juan Raposo, Manuel Álvarez, Paula Montoto, Vicente Orjales, Justo Hidalgo, Lucia Ardao, Anastasio Molano y Ángel Viña. “The DENODO Data Integration Platform”. En: Proceedings of the 28th International Conference on Very Large Data Bases (VLDB 2002), 2002. Morgan Kaufmann, pp. 986-989.

S. Chakrabarti, M. Van der Berg and B. Dom. “Focussed Crawling: A New Approach to Topic-specific Web Resource Discovery”. En: Proceedings of the 8th Internacional World Wide Web Conference, 1999.